Ollama

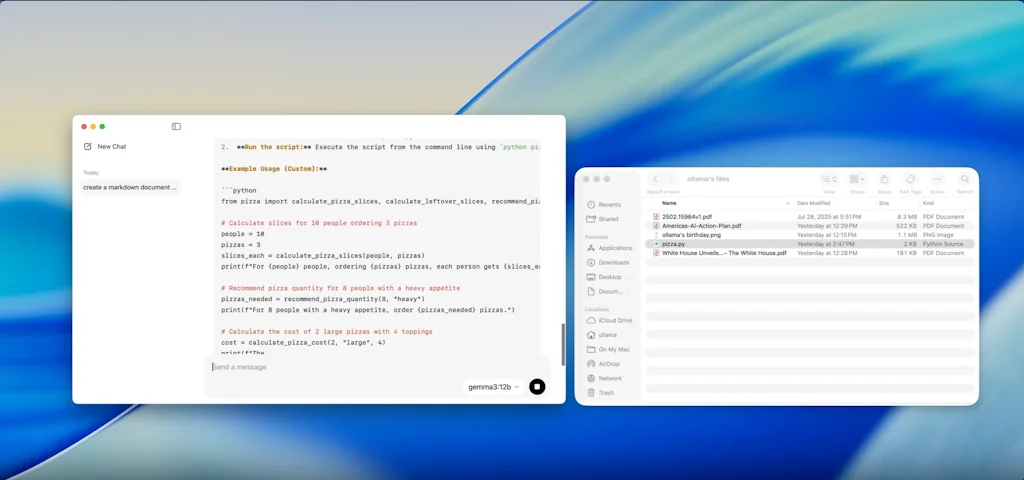

La forma más sencilla de ejecutar modelos de lenguaje grandes localmente

¿Qué es Ollama?

Ejecute Llama 2 y otros modelos en macOS, y próximamente Windows y Linux. Personaliza y crea el tuyo propio.

Pros y contras

Pros

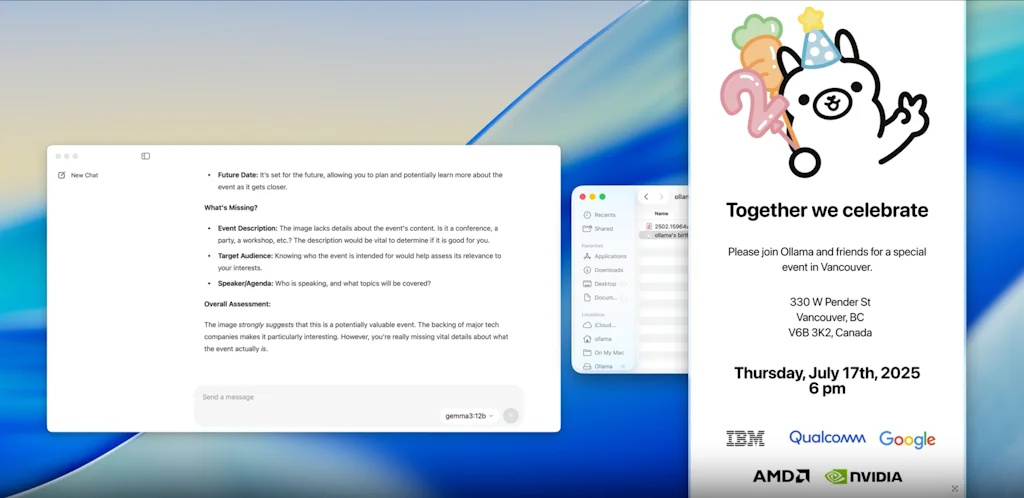

- Implementación del modelo de IA local

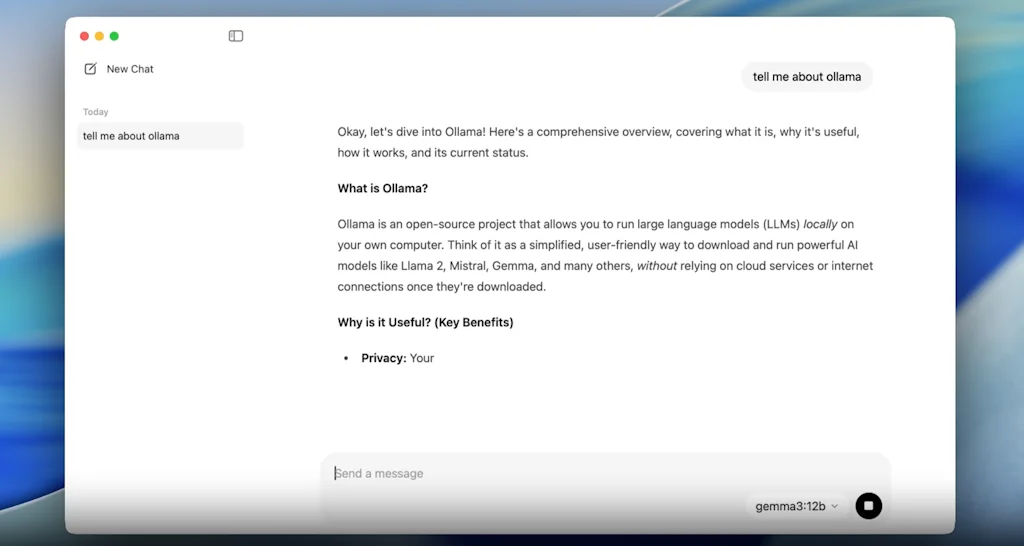

- Fácil de usar

- Alojamiento de servidor de IA

- Personalización

- Privacidad de datos

- Fácil integración

- Fácil configuración

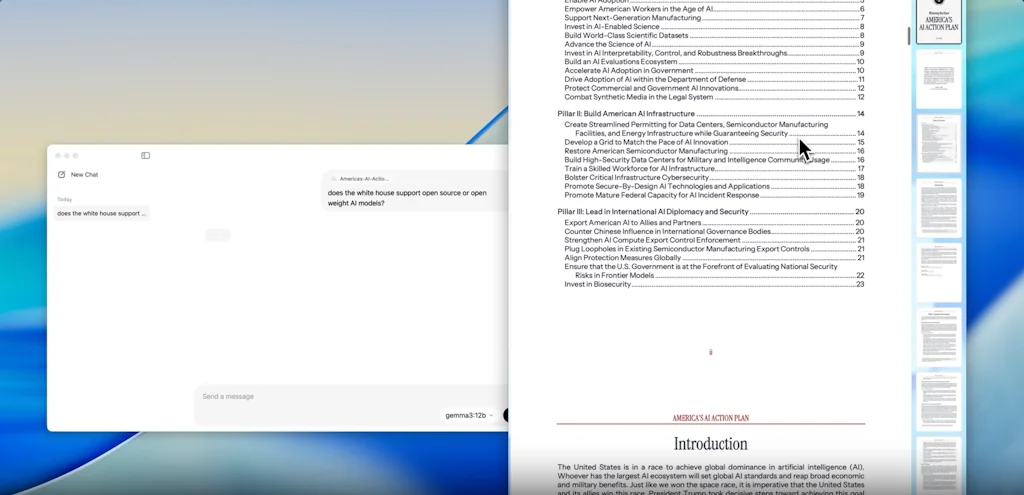

- Rendimiento rápido

- Creación rápida de prototipos

- Sin dependencia de API de terceros

- Rentable

- Nivel gratuito

- Admite modelos grandes

Contras

- Personalización de voz limitada

Detalles de la herramienta

| Categorías | Herramientas de infraestructura de IA, Herramientas para desarrolladores de LLM |

|---|---|

| Sitio web | github.com |

| Se hizo popular | 22 de agosto de 2023 |

| Plataformas | Web |

Reseñas recientes (8)

Estamos explorando Ollama para probar y ejecutar LLM localmente: iteración más rápida, latencia cero y control total. Es como tener nuestro propio laboratorio de IA, menos las facturas de la GPU

Fácil de implementar y administrar. Ollama hace que ejecutar LLM locales sea muy fácil. Combínalo con OpenWebUI para disfrutar de la mejor experiencia.

Para ejecutar y prestar servicios de LLM que las personas pueden ejecutar localmente sin frustración, hay pocos de tan alta calidad como Ollama.

No tengo idea de alternativas y, sinceramente, no siento que las necesite.

Recientemente, realicé un vuelo largo y tener ollama (con llama2) localmente realmente me ayudó a crear un prototipo de algunos cambios rápidos en nuestro producto sin tener que depender del wifi irregular del avión.

Muy fácil y potente de ejecutar y personalizar LLM locales e integrar (Langchain o LlamaIndex).

¡Eso es genial y útil! Puedo tener mi repositorio de modelos y ejecutarlos desde mi terminal

Fácil de ejecutar múltiples modelos de IA localmente sin preocuparse por problemas de privacidad.

Preguntas frecuentes sobre Ollama

¿Cuándo se hizo popular Ollama?

Ollama se hizo popular alrededor de 22 de agosto de 2023.

¿Cuáles son las principales ventajas de Ollama?

Las principales ventajas de Ollama incluyen: implementación del modelo de IA local, fácil de usar, Alojamiento de servidor de IA, personalización, privacidad de datos.

¿Cuáles son las desventajas de Ollama?

Algunas desventajas reportadas de Ollama incluyen: personalización de voz limitada.

¿Cuál es la calificación general de Ollama?

Ollama tiene una calificación general de 5.0/5 basada en 24 reseñas de usuarios.

¿Qué tipo de herramienta es Ollama?

Ollama pertenece a las siguientes categorías: Herramientas de infraestructura de IA, Herramientas para desarrolladores de LLM.

Herramientas Herramientas de infraestructura de IA relacionadas

Herramientas Herramientas para desarrolladores de LLM relacionadas

Comparar Ollama :

No te dejes engañar por videos falsos en redes sociales

El primer verificador de hechos del mundo para redes sociales. Pega cualquier enlace y obtén una puntuación de credibilidad instantánea con fuentes.

Probar FactCheckTool gratis