Ollama

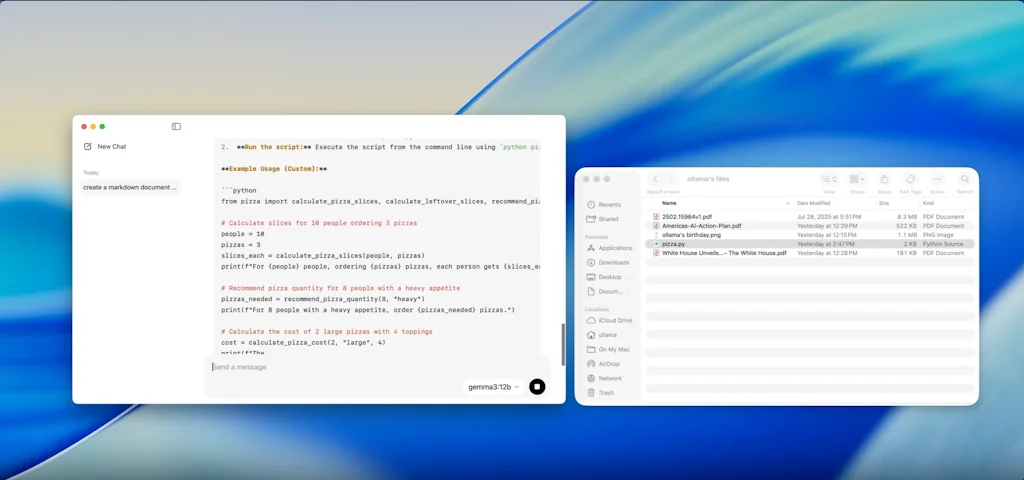

Le moyen le plus simple d'exécuter de grands modèles de langage localement

Qu'est-ce que Ollama ?

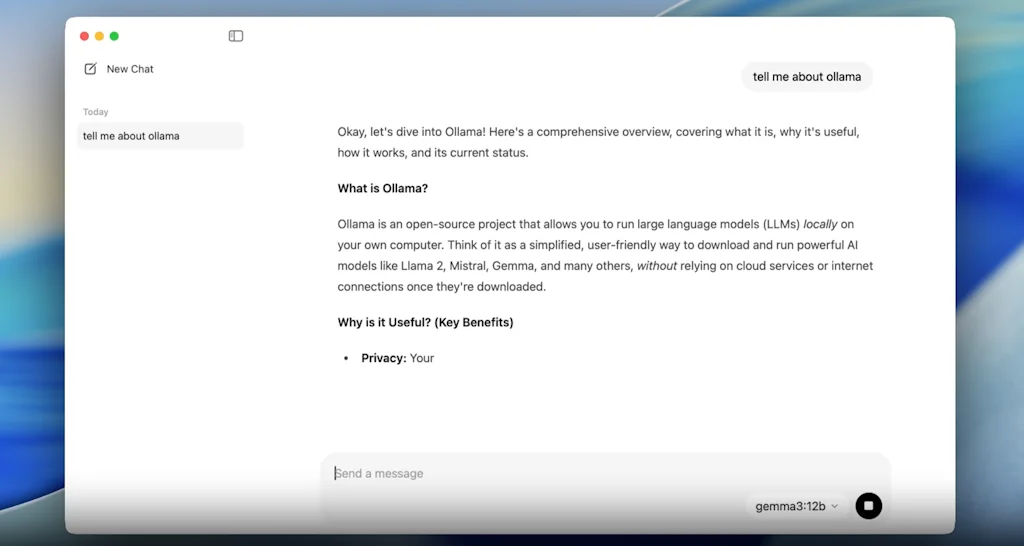

Exécutez Llama 2 et d’autres modèles sur macOS, Windows et Linux étant bientôt disponibles. Personnalisez et créez le vôtre.

Avantages et inconvénients

Avantages

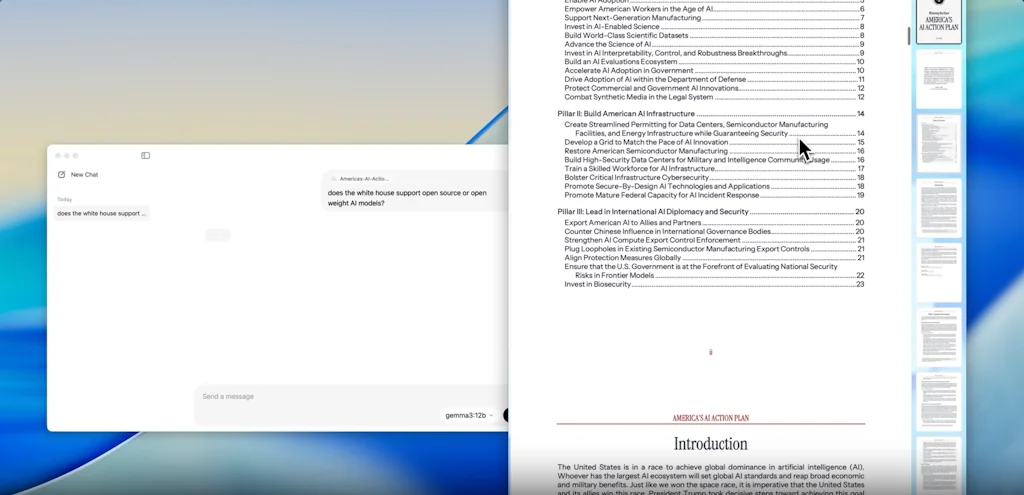

- Déploiement de modèle d'IA local

- Facile à utiliser

- Hébergement de serveur IA

- Personnalisation

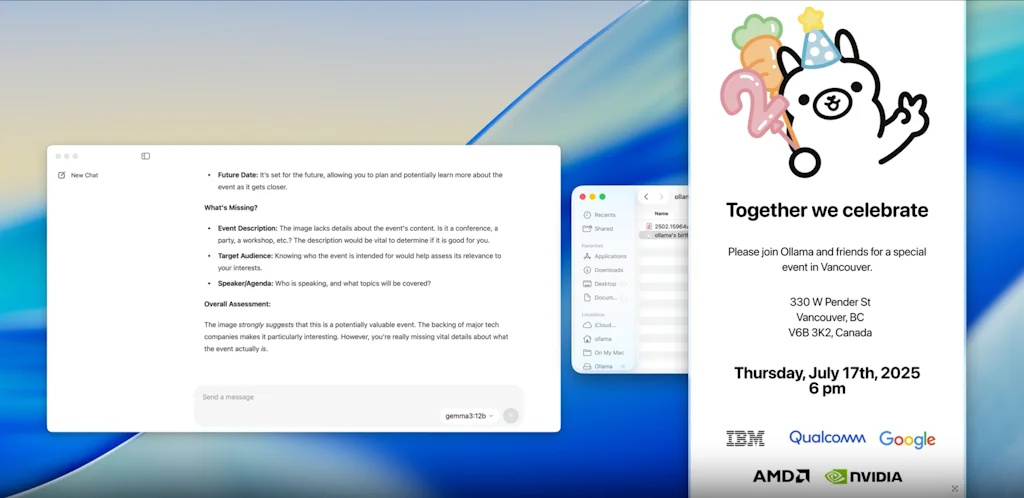

- Confidentialité des données

- Intégration facile

- Installation facile

- Performances rapides

- Prototypage rapide

- Aucune dépendance à l'API tierce

- Rentable

- Niveau gratuit

- Prend en charge les grands modèles

Inconvénients

- Personnalisation vocale limitée

Détails de l'outil

| Catégories | Outils d'infrastructure d'IA, Outils de développement LLM |

|---|---|

| Site web | github.com |

| Devenu populaire | 22 août 2023 |

| Plateformes | Web |

Avis récents (8)

Nous explorons Ollama pour tester et exécuter des LLM localement : itération plus rapide, latence nulle, contrôle total. C'est comme avoir notre propre laboratoire d'IA, sans les factures GPU

Facile à déployer et à gérer. Ollama rend la gestion de LLM locaux si simple. Associez-le à OpenWebUI pour une expérience ultime.

Pour exécuter et servir des LLM que les gens peuvent exécuter localement sans frustration, il y en a peu d'aussi haute qualité qu'Ollama.

Aucune idée d'alternatives, et sincèrement, je n'en ressens pas le besoin

Récemment, j'ai effectué un long vol et avoir ollama (avec lama2) localement m'a vraiment aidé à prototyper des modifications rapides de notre produit sans avoir à compter sur le Wi-Fi irrégulier des avions.

Très simple et puissant à exécuter et à personnaliser des LLM locaux, et à intégrer (Langchain ou LlamaIndex).

C'est cool et utile ! Je peux avoir mon référentiel de modèles et les exécuter depuis mon terminal

Il est facile d'exécuter plusieurs modèles d'IA localement sans vous soucier des problèmes de confidentialité.

Questions fréquentes sur Ollama

Quand Ollama est-il devenu populaire ?

Ollama est devenu populaire vers 22 août 2023.

Quels sont les principaux avantages de Ollama ?

Les principaux avantages de Ollama incluent : déploiement de modèle d'IA local, facile à utiliser, Hébergement de serveur IA, personnalisation, confidentialité des données.

Quels sont les inconvénients de Ollama ?

Certains inconvénients signalés de Ollama incluent : personnalisation vocale limitée.

Quelle est la note globale de Ollama ?

Ollama a une note globale de 5.0/5 basée sur 24 avis d'utilisateurs.

Quel type d'outil est Ollama ?

Ollama appartient aux catégories suivantes : Outils d'infrastructure d'IA, Outils de développement LLM.

Outils Outils d'infrastructure d'IA similaires

Outils Outils de développement LLM similaires

Comparer Ollama :

Ne vous faites pas piéger par les fausses vidéos

Le premier vérificateur de faits au monde pour les réseaux sociaux. Collez un lien et obtenez un score de crédibilité instantané avec des sources.

Essayer FactCheckTool gratuitement