Qwen 1.5 MoE

Modèle de mélange d'experts (MoE) très efficace d'Alibaba

Qu'est-ce que Qwen 1.5 MoE ?

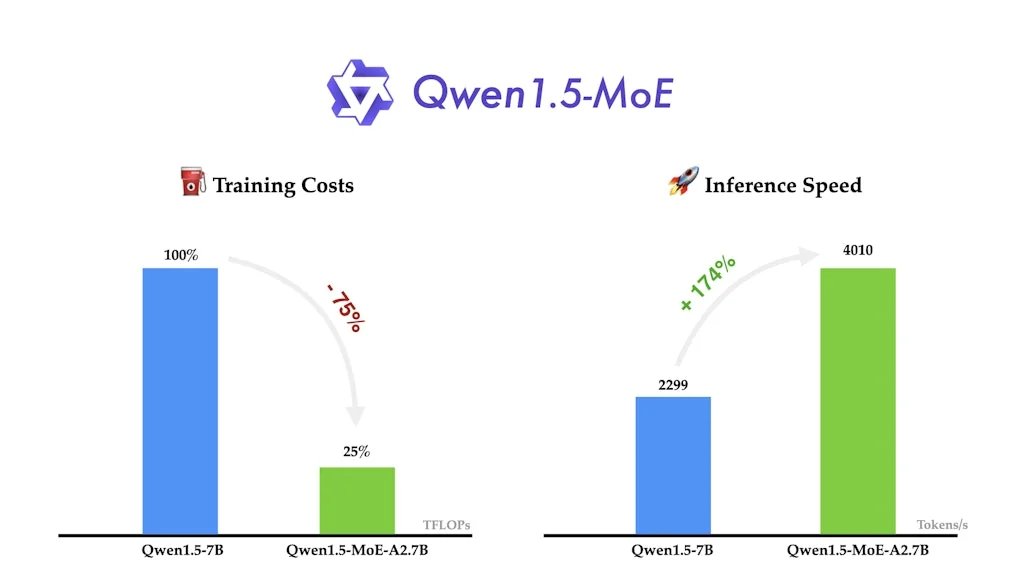

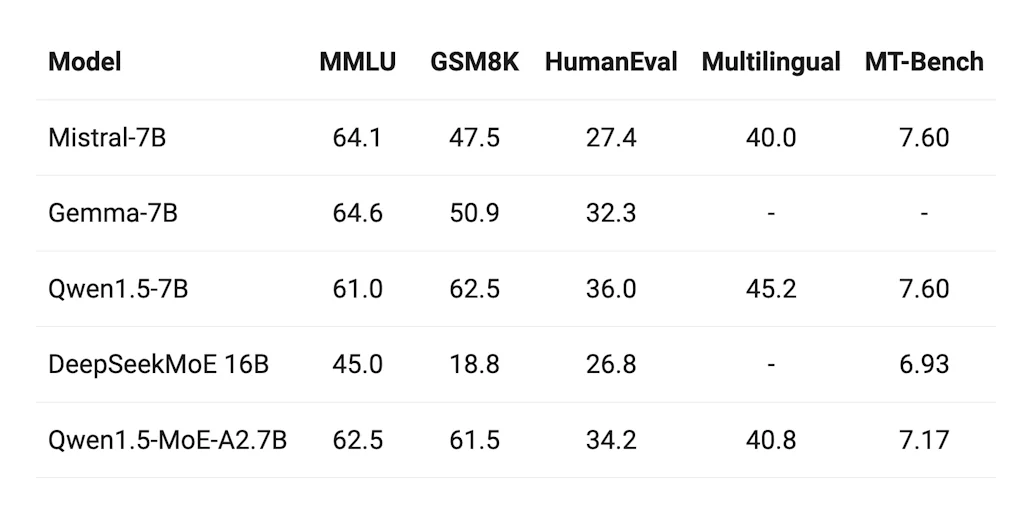

Qwen1.5-MoE-A2.7B est un petit modèle mixte d'experts (MoE) avec seulement 2,7 milliards de paramètres activés, mais qui correspond aux performances des modèles 7B de pointe comme Mistral 7B et Qwen1.5-7B.

Détails de l'outil

| Catégories | LLM, Outils d'infrastructure d'IA |

|---|---|

| Site web | huggingface.co |

| Devenu populaire | 3 avril 2024 |

| Plateformes | Web |

Avis récents (1)

S

★★★★★

Modèles de base hautement performants pouvant être utilisés pour une formation spécifique à des tâches. Comme l'expérience d'appel de fonction intégrée à Arch

Questions fréquentes sur Qwen 1.5 MoE

Quand Qwen 1.5 MoE est-il devenu populaire ?

Qwen 1.5 MoE est devenu populaire vers 3 avril 2024.

Quelle est la note globale de Qwen 1.5 MoE ?

Qwen 1.5 MoE a une note globale de 5.0/5 basée sur 2 avis d'utilisateurs.

Quel type d'outil est Qwen 1.5 MoE ?

Qwen 1.5 MoE appartient aux catégories suivantes : LLM, Outils d'infrastructure d'IA.

Outils LLM similaires

Outils Outils d'infrastructure d'IA similaires

Comparer Qwen 1.5 MoE :

Ne vous faites pas piéger par les fausses vidéos

Le premier vérificateur de faits au monde pour les réseaux sociaux. Collez un lien et obtenez un score de crédibilité instantané avec des sources.

Essayer FactCheckTool gratuitement