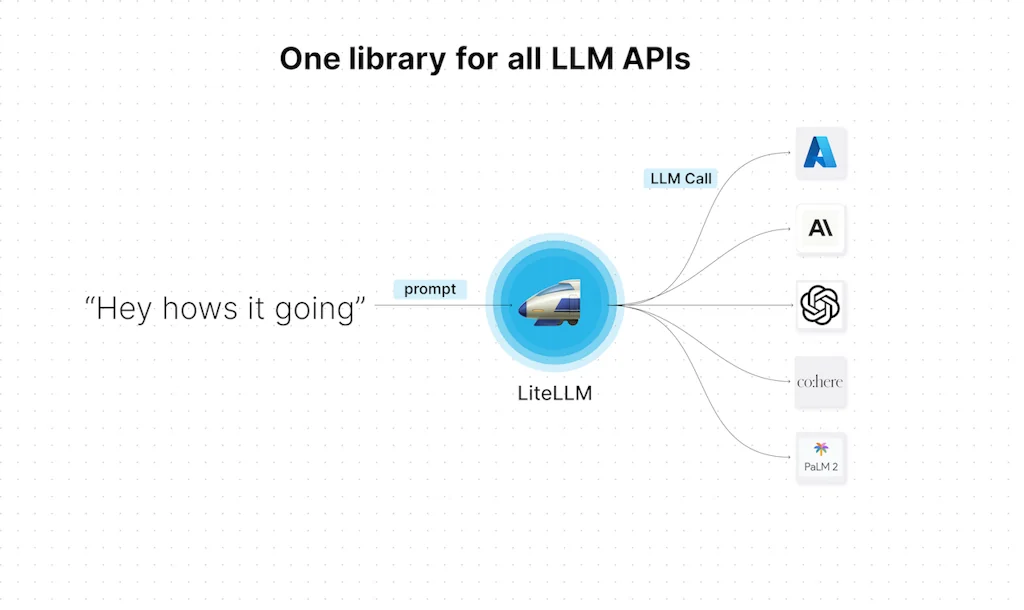

Was ist liteLLM?

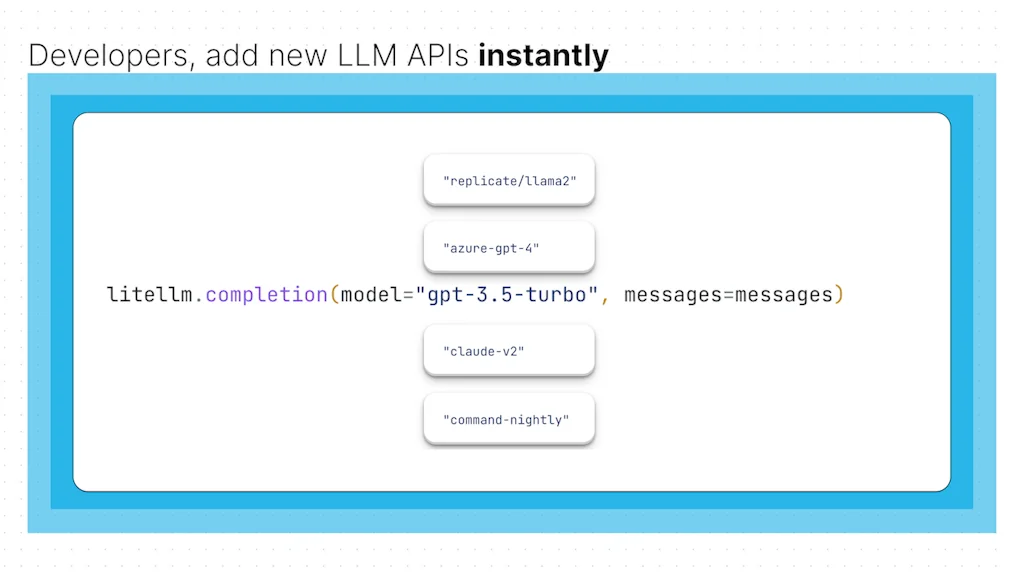

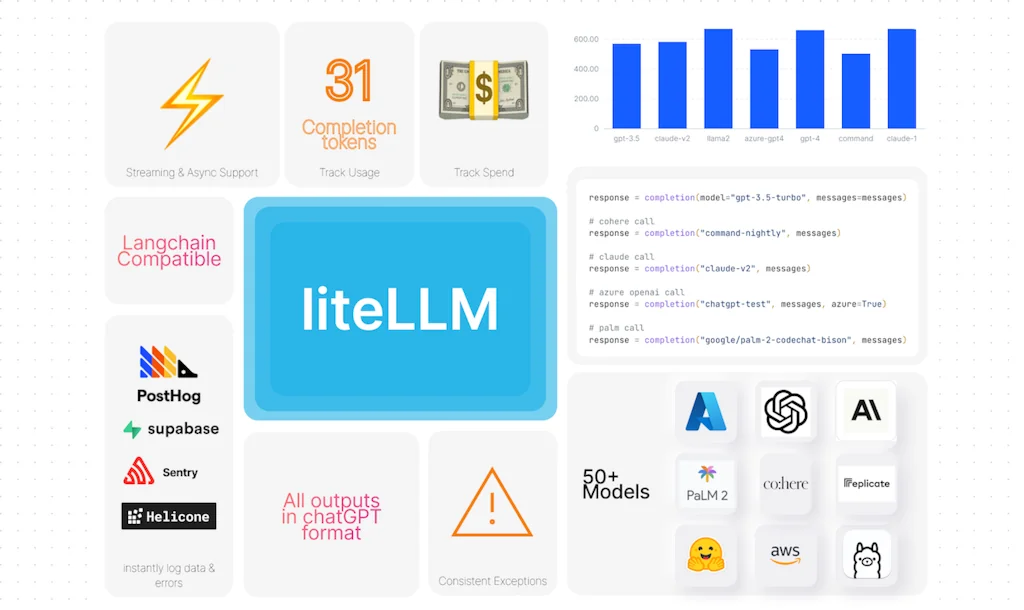

Vereinfachen Sie die Verwendung von OpenAI-, Azure-, Cohere-, Anthropic-, Replicate- und Google LLM-APIs. TLDR Rufen Sie alle LLM-APIs im ChatGPT-Format auf – Vervollständigung (Modell, Nachrichten). Konsistente Ausgaben und Ausnahmen für alle LLM-APIs. Protokollierung und Fehlerverfolgung für alle Modelle

Vor- und Nachteile

Vorteile

- Unterstützung für benutzerdefinierte Modelle

- Caching und Lastausgleich

- Einfacher Anbieterwechsel

- OpenAI-kompatible API

- Integration der Leistungsanalyse

- Standardisierte API

- Einheitliche Schnittstelle für LLMs

- Vielseitiger API-Aufruf

Tool-Details

| Kategorien | Einheitliche API, KI-Infrastruktur-Tools |

|---|---|

| Webseite | github.com |

| Wurde populär | 9. August 2023 |

| Plattformen | Web |

| Soziale Medien | Twitter · GitHub |

Aktuelle Bewertungen (4)

liteLLM ist ein Muss für die Arbeit mit verschiedenen Modellen. Wir verwenden unterschiedliche Modelle für unterschiedliche Aufgaben und Teilaufgaben. Mit liteLLM bleibt der Code genau derselbe und wir können uns nur auf die Auswahl der richtigen Eingabeaufforderungen und Modelle für die Aufgabe konzentrieren.

Großer Fan von liteLLM: eine API für OpenAI/Anthropic/Groq/etc. Macht Multi-Modell-Stacks schmerzlos

Ich empfehle diese Bibliothek ernsthaften LLM-basierten App-Entwicklern, die versuchen, ihre Codebasis zu standardisieren, indem sie alle von ihnen verwendeten APIs vereinheitlichen. Ich liebe es!

Als LLM-Proxy verwendet, ermöglicht es das Caching und den Lastausgleich zwischen mehreren KI-Diensten (Groq, OpenRouter usw.) und sogar lokal mit Ollama. Es verwendet eine OpenAI-kompatible API, die die Verwendung in vielen Apps oder Diensten ermöglicht (sofern wir die Basis-URL festlegen können). Ich verwende es konfiguriert mit Langfuse, das die Leistungsanalyse (Überwachung) jeder Eingabeaufforderung/Sitzung ermöglicht.

Häufig gestellte Fragen zu liteLLM

Wann wurde liteLLM populär?

liteLLM wurde um 9. August 2023 populär.

Was sind die Hauptvorteile von liteLLM?

Die wichtigsten Vorteile von liteLLM sind: Unterstützung für benutzerdefinierte Modelle, Caching und Lastausgleich, einfacher Anbieterwechsel, OpenAI-kompatible API, Integration der Leistungsanalyse.

Wie ist die Gesamtbewertung von liteLLM?

liteLLM hat eine Gesamtbewertung von 5.0/5 basierend auf 17 Nutzerbewertungen.

Was für ein Tool ist liteLLM?

liteLLM gehört zu folgenden Kategorien: Einheitliche API, KI-Infrastruktur-Tools.

Verwandte Einheitliche API Tools

Verwandte KI-Infrastruktur-Tools Tools

liteLLM vergleichen :

Lassen Sie sich nicht von gefälschten Videos täuschen

Der weltweit erste Faktenprüfer für soziale Medien. Fügen Sie einen Link ein und erhalten Sie sofort einen Glaubwürdigkeitsscore mit Quellen.

FactCheckTool kostenlos testen