liteLLM

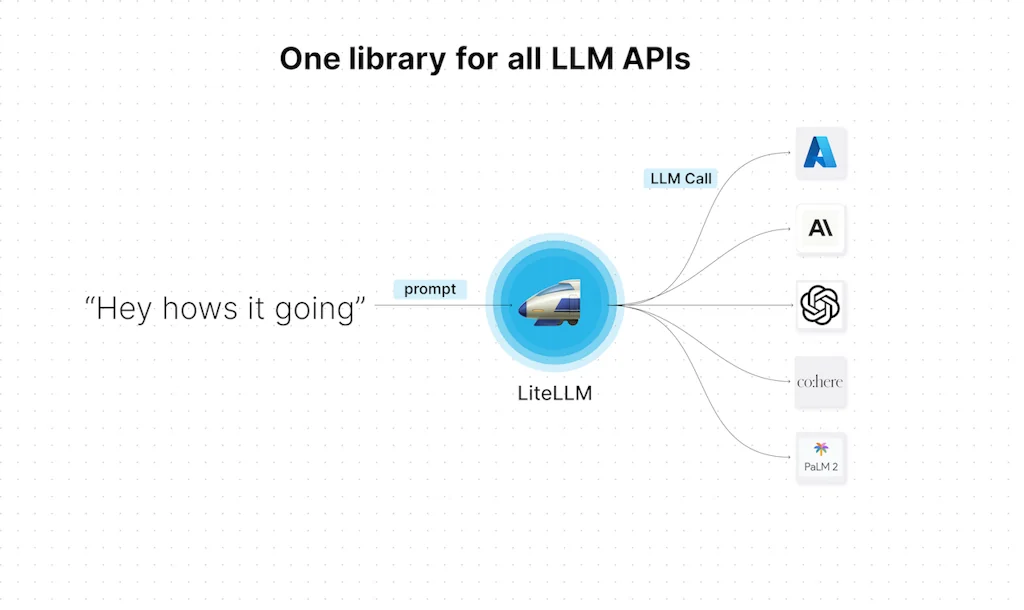

Une bibliothèque pour standardiser toutes les API LLM

Qu'est-ce que liteLLM ?

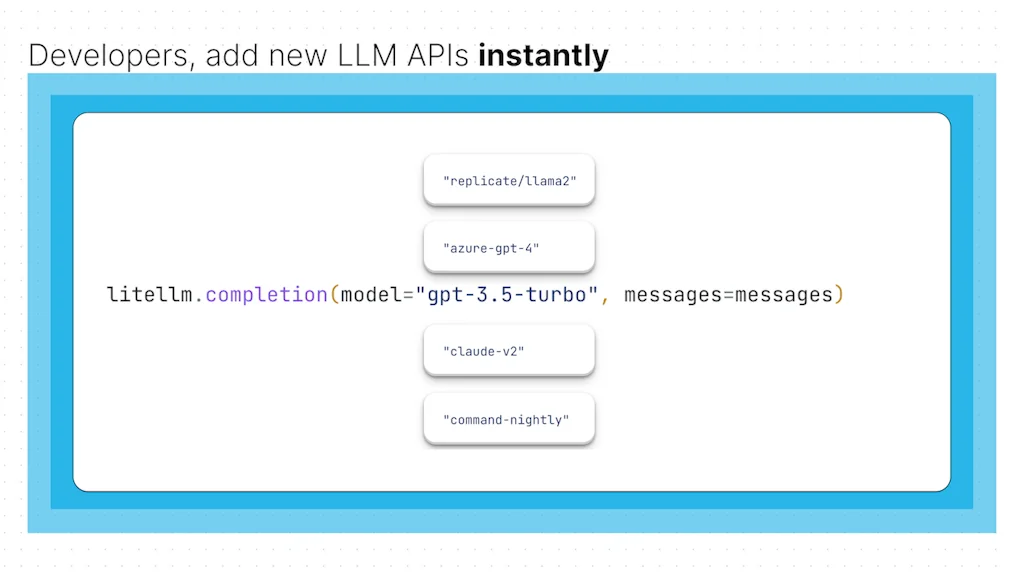

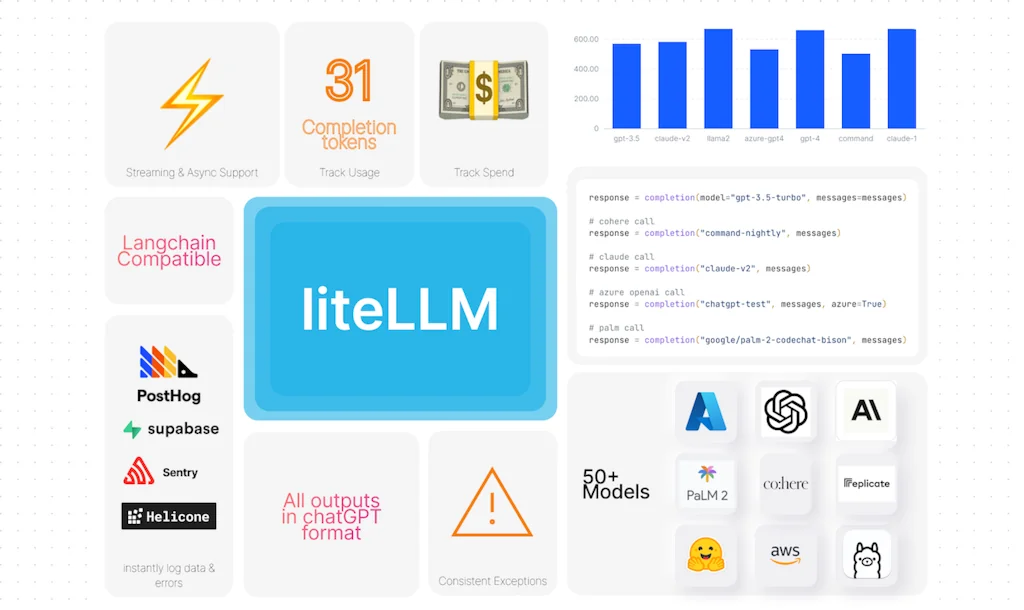

Simplifiez-vous en utilisant les API OpenAI, Azure, Cohere, Anthropic, Replicate et Google LLM. TLDR Appel de toutes les API LLM en utilisant le format chatGPT - achèvement (modèle, messages) Sorties et exceptions cohérentes pour toutes les API LLM Journalisation et suivi des erreurs pour tous les modèles

Avantages et inconvénients

Avantages

- Prise en charge des modèles personnalisés

- Mise en cache et équilibrage de charge

- Changement facile de fournisseur

- API compatible OpenAI

- Intégration de l'analyse des performances

- API standardisée

- Interface unifiée pour les LLM

- Appels API polyvalents

Détails de l'outil

| Catégories | API unifiée, Outils d'infrastructure d'IA |

|---|---|

| Site web | github.com |

| Devenu populaire | 9 août 2023 |

| Plateformes | Web |

| Réseaux sociaux | Twitter · GitHub |

Avis récents (4)

liteLLM est indispensable pour travailler avec différents modèles. Nous utilisons différents modèles pour différentes tâches et sous-tâches. Avec liteLLM, le code reste exactement le même et nous pouvons simplement nous concentrer sur le choix des invites et des modèles adaptés à la tâche.

Grand fan de liteLLM : une API pour OpenAI/Anthropic/Groq/etc. Rend les piles multimodèles indolores

Je recommande cette bibliothèque aux développeurs d'applications sérieux basés sur LLM qui tentent de standardiser leur base de code en unifiant toutes les API qu'ils utilisent. Aimer!

Utilisé comme proxy LLM, il permet la mise en cache et l'équilibrage de charge entre plusieurs services d'IA (Groq, OpenRouter, etc.) et même en local avec Ollama. Il utilise une API compatible OpenAI qui permet (quand on peut définir l'URL de base) de l'utiliser dans de nombreuses applications ou services. Je l'utilise configuré avec Langfuse qui fournit l'analyse des performances (surveillance) de chaque invite/session.

Questions fréquentes sur liteLLM

Quand liteLLM est-il devenu populaire ?

liteLLM est devenu populaire vers 9 août 2023.

Quels sont les principaux avantages de liteLLM ?

Les principaux avantages de liteLLM incluent : prise en charge des modèles personnalisés, mise en cache et équilibrage de charge, changement facile de fournisseur, API compatible OpenAI, intégration de l'analyse des performances.

Quelle est la note globale de liteLLM ?

liteLLM a une note globale de 5.0/5 basée sur 17 avis d'utilisateurs.

Quel type d'outil est liteLLM ?

liteLLM appartient aux catégories suivantes : API unifiée, Outils d'infrastructure d'IA.

Outils API unifiée similaires

Outils Outils d'infrastructure d'IA similaires

Comparer liteLLM :

Ne vous faites pas piéger par les fausses vidéos

Le premier vérificateur de faits au monde pour les réseaux sociaux. Collez un lien et obtenez un score de crédibilité instantané avec des sources.

Essayer FactCheckTool gratuitement